清华大学沈向洋教授快手直播:要避免传统社会语境里的偏见被带入AI

-

科技滚动

正文

当下,以人工智能为代表的新兴技术正在让很多不可思议的事情成为现实。但在推动技术进步的同时,如何解决技术带来的社会影响?如何避免人工智能技术发展带来的偏见和歧视?也是全人类需要共同关注的问题。

2019年底,前微软全球执行副总裁沈向洋宣布离职后,去向一直备受关注。3月3日,沈向洋入职清华大学拥抱学术的消息传出。

3月5日上午九点,刚刚续聘清华大学高等研究院双聘教授的沈向洋博士,通过清华大学快手官方账号(快手ID:Tsinghua_1911)直播,为清华学子和广大网友上了特殊的公开课《打造负责任的AI》(Engineering Responsible AI),差不多1个小时间里,直播间总观看人数近10万人。

在近年的科技浪潮中,沈向洋一直主张打造负责任的、可信赖的人工智能。他认为,我们不仅要推动技术的进步,更要认真思考可能由此带来的社会影响,以及人类将要共同面对的潜在挑战,未雨绸缪。

演讲的前半部分,沈向洋解释了explainable AI(可解释的人工智能)对于如何打造负责任的AI的重要性。“人工智能已经开始做出人类无法理解的决定了。我们需要开启人工智能的黑箱,了解AI做出决定背后的原因。”

今天AI最大的突破就是深度学习,但是深度学习的一个最大的问题就是,出来的结果非常好,但是人们没办法解释。所以Explainable AI在接下来的AI领域探索中非常重要。沈向洋称:“今天我如果有研究生的话,我就建议他们做这个方向的工作。”

在演讲的后半部分,沈向洋提出了“技术的偏见”问题。在训练人工智能系统时,一些社会偏见可能会导致对数据集在个人的性别、肤色和年龄假设。但在多元化的社会中,肤色、口音等各种不同的特征和差异也让我们意识到,满足所有人的不同需求是非常复杂的。

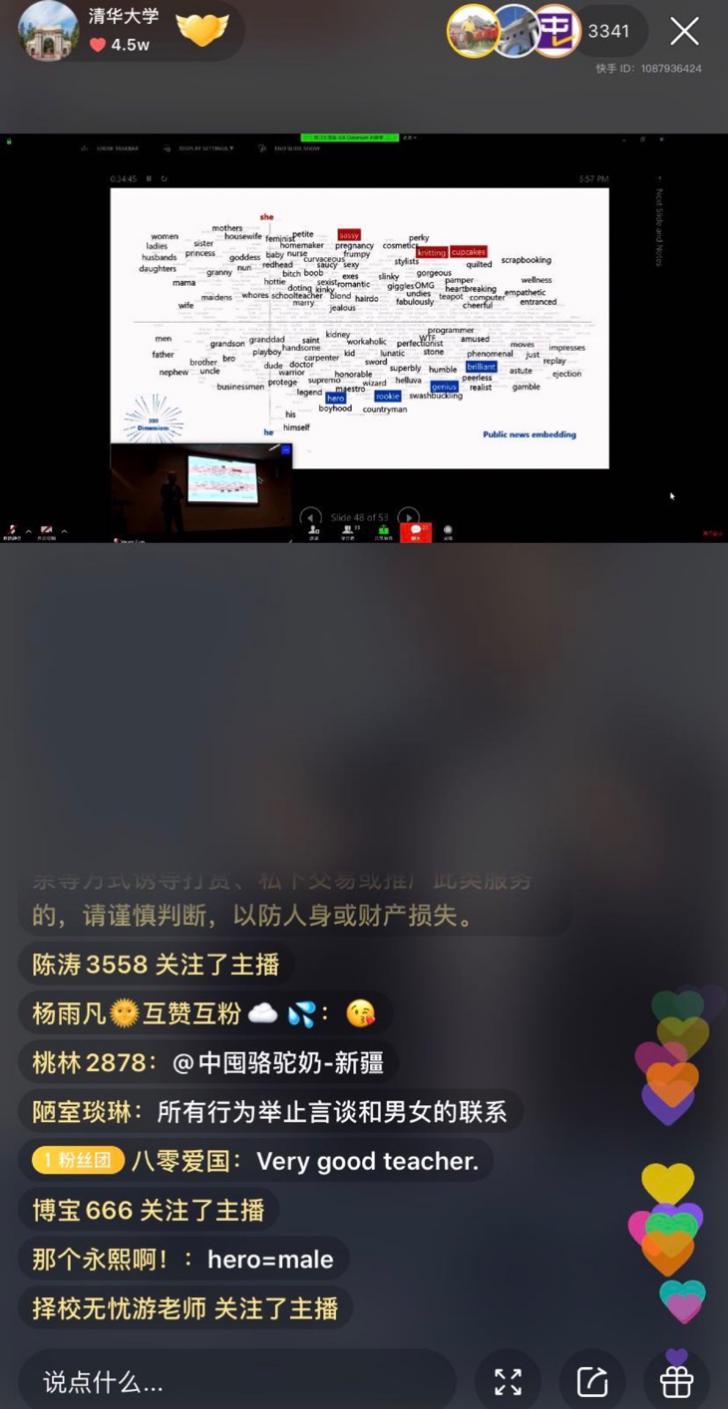

他举了文本搜索中性别偏见的例子。研究团队利用称为“单词嵌入”的自然语言处理工具,将单词转换为向量数字的算法,以来自新闻数据或者网页数据的海量文本数据为依据,为每个单词赋予一个对应的向量数字。通过在向量坐标系中,比对常见词汇与“他”、“她”这两个性别代词之间的关联度,研究人员发现了一些明显的特征,例如“sassy(刁蛮)”、“knitting(编织)”这样的词更靠近女性,而“hero(英雄)”、“genius(天才)”更靠近男性。

算法之所以会为这些词汇赋予性别特征,原因在于训练算法用的基准数据集通常是来自新闻和网页的数据,就存在着由语言习惯造成的“性别偏见”,算法也自然“继承”了人类对这些词汇理解的性别差异。其结果就是,当微软用试验算法,根据梅林达·盖茨的LinkedIn信息推测其职业时,得到了“教师”的判断,但人物性别换成“他”,盖茨夫人的职业就会变为“律师”。

我们离explainable AI和完全消除技术偏见还有很长的路要走。找出对所有人都公平的处理方法需要所有人的共同努力。为此他在课上介绍了自己与微软公司总裁施博德(Brad Smith)联袂编著《计算未来:人工智能及其社会角色》中提出的“六大原则”:公平、可靠和安全、隐私和保障、包容、透明、负责。这六大原则旨在引导人工智能的跨越和运用,更好服务世界。

作为计算机视觉和图形学研究的世界级专家,沈向洋专注于计算机视觉、图形学、人机交互、统计学习、模式识别和机器人等方向的研究工作。他在微软工作了23年,曾是微软领导结构中位置最高的华人,被外界誉为‘微软在中国的形象大使’。

离开微软后,沈向洋在清华开启了人生新篇章。在沈向洋开课前,清华大学快手账号直播了“沈向洋双聘教授聘任仪式”,清华大学校长邱勇宣布沈向洋为清华双聘教授。

在共同的普惠教育价值观推动下,清华大学于2019年10月正式入驻快手,目前粉丝已经超过150万,开展了一系列精品课程直播。

今年2月3日,清华大学全校师生通过学堂在线雨课堂、快手等平台同上一堂课,在社会上引起了巨大反响,随后快手与学堂在线建立战略合作,双方将在内容共享、直播技术支持等方面建立深层次合作。此次沈向洋教授的快手直播,让更多渴望了解前沿技术知识的人们有机会聆听世界级专家的课程。

评论 {{userinfo.comments}}

-

{{child.nickname}}

{{child.create_time}}{{child.content}}

{{question.question}}

提交

石头科技最新旗舰G30S Pro即将上市,导航系统全面升级,避障与越障能力跨代跃迁

昨夜今晨:中国汽车产销量连续17年全球第一 市监总局对携程启动反垄断调查

万亿规模的二手车市之下,瓜子如何破除信任困局?

昨夜今晨:去年全国二手车交易量再创新高 中科大团队突破全固态电池技术瓶颈

驱动号 更多